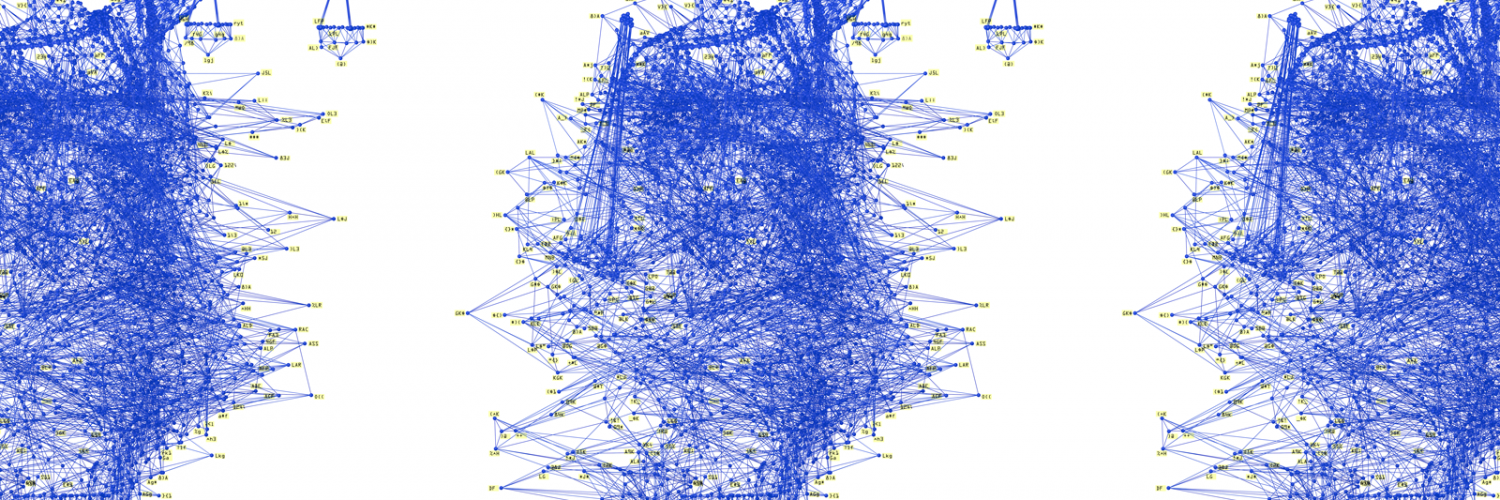

O consórcio formado pelas maiores empresas de tecnologia dos Estados Unidos (Apple, Amazon, Facebook, Microsoft, IBM, Nvidia e Alphabet / Google) em conjunto com organizações como a Anistia Internacional ou Human Rights Watch, divulgou na última sexta-feira um relatório no qual se posiciona contra o uso de algoritmos de inteligência artificial como método de tomada de decisões de natureza criminal.

De acordo com esta organização, chamada ‘Partnership on AI‘, as autoridades (juízes, funcionários de fiança ou liberdade condicional) devem abster-se do uso de AI para decidir quem deve ser liberado ou não com base em cálculos sobre a possibilidade de reincidência, uma vez que é um método potencialmente enviesado, opaco, e também é sobrecarregado por definições pouco claras do que constitui “alto risco” ou “baixo risco”.

Estas empresas se opõem ao uso da AI enquanto não for devidamente regulamentada, mas se queixam de que os políticos estão começando a adotá-lo amplamente nos Estados Unidos (recebeu um impulso especial nos últimos meses, após a aprovação do primeiro ato Passo ), e que até começa a ganhar seguidores em outros países.

Na verdade, as grandes empresas do Vale do Silício estão se posicionando cada vez mais claramente contra o uso que é dado aos algoritmos de previsão, apesar do fato de que eles próprios ajudaram a desenvolver este tipo de tecnologia em muitos casos. E, na verdade, muitos eles continuam a usá-los (os dados) como propaganda para seus negócios de computação em nuvem.

Alice Xiang, pesquisadora do consórcio, explica a motivação para a criação deste relatório: “é realmente na justiça criminal onde estas questões são cruciais, porque na verdade estamos falando sobre a tomada de decisões […] que podem ter profundas ramificações e inflexões para a vida de indivíduos e outros membros de sua comunidade “.

O caso COMPAS

Um dos exemplos mais claros dos perigos éo caso do algoritmo COMPAS (Correctional Offender Management Profiling for Alternative Sanctions) da companhia Equivant: em 2016, a organização de notícias ProPublica denunciou haver detectado que COMPAS apresentou duas vezes mais probabilidades de rotular incorretamente réus negros como futuros reincidentes, do que réus brancos.

Estudos acadêmicos subseqüentes confirmaram que o algoritmo não mostrou mais precisão em suas estimativas do que naquelas feitas por humanos sem treinamento especializado. E apesar disso, em muitos lugares, o algoritmo continuou a ser usado.

Logan Koepke, analista sênior de políticas Upturn (organização membro da Parceria sobre AI que promove a equidade no uso da tecnologia digital), o relatório “destaca a nível estatístico e técnico, o quão longe estamos ainda estar preparados para implementar o uso dessas ferramentas de forma responsável.”

/cdn.vox-cdn.com/uploads/chorus_image/image/58358003/acastro_170629_1777_0008.0.jpg)